Les petits modèles de langage (SLM) redessinent le paysage de l'intelligence artificielle en entreprise. Selon Gartner, ces modèles compacts vont supplanter les LLM pour la majorité des cas d'usage professionnels. Cette évolution stratégique transforme radicalement la donne technologique.

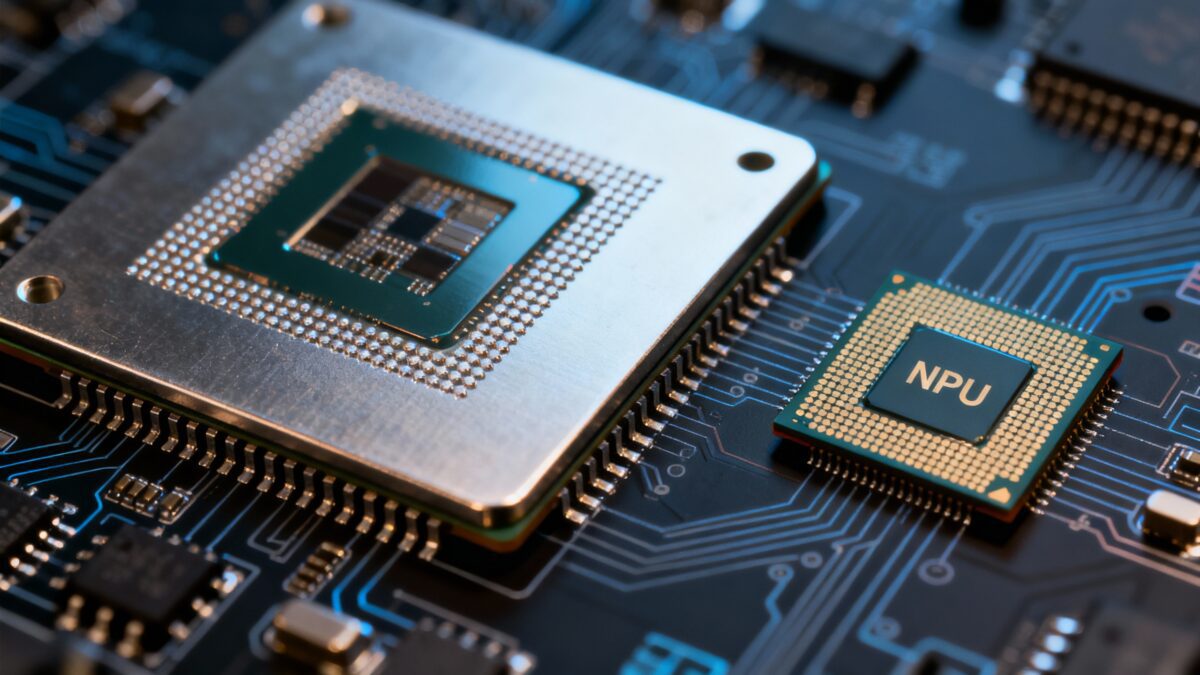

La compacité des SLM permet désormais de déployer l'IA directement sur des appareils mobiles hors ligne, ouvrant la voie à des architectures locales sécurisées. Cette nouvelle ère soulève une question cruciale pour maximiser le retour sur investissement (ROI) : quel processeur choisir pour faire tourner ces modèles optimisés ?

GPU : La solution polyvalente aux coûts opérationnels élevés

Le GPU (Graphics Processing Unit) demeure la référence historique pour l'IA. Son architecture parallèle excelle dans l'entraînement des modèles et offre une flexibilité maximale.

Cependant, pour l'inférence en production, le GPU présente un ratio performance/watt défavorable. Son architecture généraliste génère une consommation énergétique disproportionnée, surtout pour des tâches d'inférence sur des SLM.

NPU : L'architecture spécialisée pour l'inférence efficace

Le NPU (Neural Processing Unit) représente une rupture technologique. Conçu spécifiquement pour les opérations de réseaux de neurones, il offre des avantages décisifs :

- Une efficacité énergétique jusqu'à 10x supérieure.

- Des temps de latence réduits de 50 à 80 %.

- Une architecture optimisée pour les SLM qui nécessitent moins de puissance de calcul.

Impact Financier : Analyse du Coût Total de Possession (TCO)

Le Coût Total de Possession dépasse largement le prix d'achat initial de l'infrastructure. L'analyse sur 36 mois révèle des différences majeures entre les architectures GPU et NPU.

Performance Opérationnelle

Les NPU réduisent la latence de 40 %, améliorant significativement la réactivité des applications métier. Les SLM exécutent déjà les requêtes à grande vitesse, et le NPU amplifie cet avantage.

Économies d'Exploitation

La consommation électrique divisée par 4 et les besoins de refroidissement réduits de 60 % génèrent des économies substantielles. Sur 3 ans, le TCO d'une infrastructure NPU peut être inférieur de 35 % à son équivalent GPU.

Souveraineté des Données

Le déploiement local des SLM sur NPU élimine les risques de fuite de données vers le cloud, garantissant une IA souveraine et maîtrisée.

Recommandations Stratégiques

Le choix du processeur dépend de la phase et de l'objectif du projet IA :

Le GPU reste indispensable pour :

- La recherche et développement (R&D).

- L'entraînement de nouveaux modèles.

- Les environnements nécessitant une flexibilité maximale.

Le NPU devient la solution de choix pour :

- Le déploiement en production de SLM spécialisés.

- Les applications à forte contrainte énergétique.

- Les architectures d'edge computing.

Cette approche rend l'IA plus accessible et responsable financièrement tout en garantissant des performances optimales.

Conclusion

L'évaluation d'une solution IA doit impérativement intégrer l'analyse du couple modèle-processeur. Cette combinaison déterminera la transformation de votre projet technique en un véritable levier de croissance mesurable.